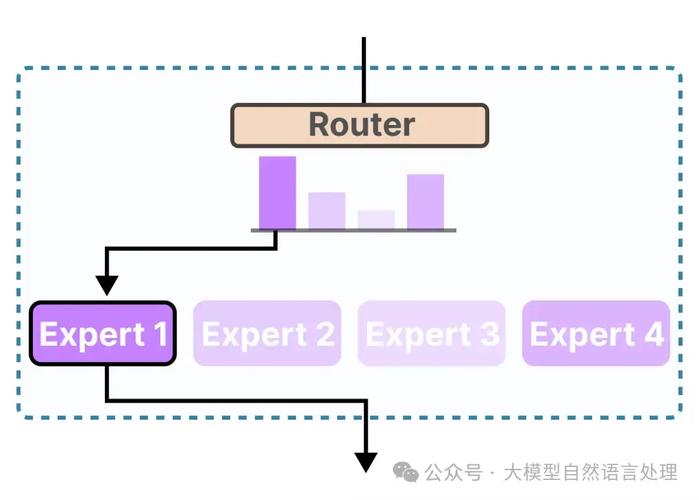

DeepEP 是 DeepSeek 开源的首个专为混合专家模型(MoE)训练和推理设计的开源 EP(专家并行)通信库。提供了高吞吐量和低延迟的全对全 GPU 内核,支持节点内和节点间的 NVLink 和 RDMA 通信。DeepEP 特别针对 论文中的组限制门控算法进行了优化,支持 FP8 数据格式调度,引入了基于 Hook 的通信-计算重叠方法,不占用 GPU 计算资源。低延迟内核在推理解码阶段表现出色,延迟低至 163 微秒。DeepEP 适用于 Hopper GPU 架构,需要 Python 3.8、CUDA 12.3 和 PyTorch 2.1 及以上版本。

全部评论

留言在赶来的路上...

发表评论