LoRA最新最权威的一切都在这了,2025综述

引言:为什么LoRA如此重要?

在人工智能快速发展的今天,大型基础模型(如GPT、BERT等)已经成为AI应用的核心基石。然而,这些动辄数十亿甚至数万亿参数的模型给开发者带来了巨大的计算资源压力。传统的全参数微调方法不仅需要大量的计算资源,还面临着训练不稳定、容易过拟合等问题。在这样的背景下,低秩适应(Low-Rank Adaptation,简称LoRA)技术应运而生,它通过巧妙的数学设计,实现了高效且灵活的模型适应方案。

本文将深入剖析LoRA技术的核心原理、最新进展及其在实际应用中的关键策略。

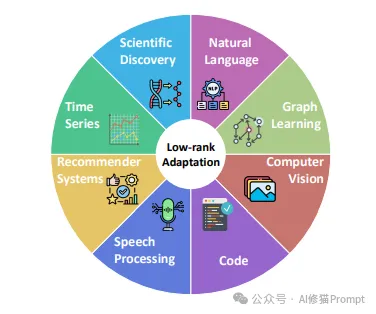

LoRA技术已在人工智能的多个核心领域获得广泛应用。该图采用放射状布局,将"Low-rank Adaptation"置于中心,周围环绕着8个主要应用领域:

- 科学发现(浅蓝色区块):适用于分子模型和科学计算

- 自然语言处理(紫色区块):涵盖文本生成、理解和翻译

- 图学习(浅绿色区块):应用于社交网络、知识图谱

- 计算机视觉(褐红色区块):包括图像识别、分割和生成

- 代码处理(深紫色区块):用于代码生成、理解和转换

- 语音处理(深蓝色区块):覆盖语音识别、合成等领域

- 推荐系统(橙色区块):服务于个性化推荐和用户行为分析

- 时间序列(绿色区块):应用于金融预测、趋势分析等场景

这种多领域的广泛应用充分证明了LoRA技术的普适性和实用价值。

LoRA的突破:颠覆传统微调范式

核心原理:低秩分解的精妙设计

LoRA的核心思想是利用矩阵的低秩特性来降低微调过程中的参数量。具体来说,它不直接更新预训练模型的权重矩阵W,而是引入两个低秩矩阵A和B,通过它们的乘积BA来表示权重更新ΔW。这种设计基于一个重要发现:模型在微调过程中的权重更新通常位于一个低维子空间中。通过将原本高维的权重更新压缩到低维空间,LoRA显著减少了需要训练的参数数量,同时保持了模型的表达能力。

例如,对于一个维度为d×k的权重矩阵,传统微调需要更新d×k个参数,而使用秩为r的LoRA只需要更新r×(d+k)个参数,当r远小于min(d,k)时,参数量的减少是显著的。研究表明,在大多数情况下,设置r为4-16就能达到接近全参数微调的效果。

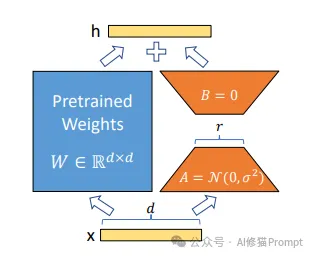

LoRA适配器的核心工作原理可以通过其结构组成清晰地理解:

1.输入输出结构

- 底部黄色条形代表输入向量x

- 顶部黄色条形代表输出向量h

- 箭头指示数据流向

2.预训练权重模块(左侧蓝色方块)

- 维度为W ∈ ℝ^(d×d)的预训练权重

- 在微调过程中保持冻结状态

3.低秩适应模块(右侧组件)

- 上部三角形:初始化为B = 0

- 下部梯形:初始化为A = N(0,σ²)

- 中间参数r控制低秩表示的维度

训练策略:精心设计的优化方案

LoRA采用了一系列巧妙的训练策略来确保微调的稳定性和效果:

1.初始化策略:矩阵A通常使用高斯分布初始化,而矩阵B初始化为零矩阵。这样的设计确保了在训练开始时,LoRA的更新不会对模型的原始行为产生影响。

2.缩放因子:引入缩放因子α/r来控制更新的幅度,这个设计使得不同秩的LoRA可以使用相似的学习率,简化了超参数调优的过程。

3.梯度更新:只有低秩矩阵A和B接收梯度更新,原始模型参数保持冻结,这不仅降低了内存占用,还能防止灾难性遗忘。

参数效率优化:多维度的突破

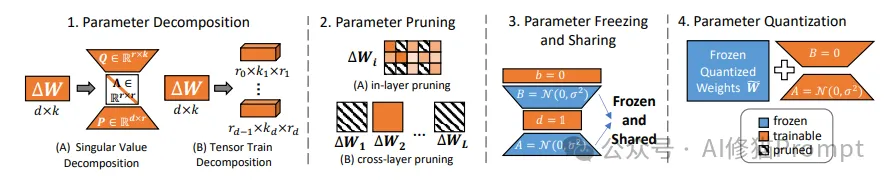

该图展示了四种提升参数效率的核心方法,每种方法都通过独特的可视化方式呈现其工作机制:

1. 参数分解(左一区域)

1.奇异值分解(图A)

- 将权重更新矩阵ΔW分解为低秩形式

- 使用三角形符号表示分解后的矩阵

- 维度标注为d×k

2.张量分解(图B)

- 展示了张量轨迹分解方法

- 将高维张量分解为多个小矩阵

- 标注尺寸为σr1×σr2

2. 参数剪枝(左二区域)

1.层内剪枝

- 展示了单层内的参数选择性剪枝

- 使用网格表示参数矩阵

- 突出显示被保留的重要参数

2.跨层剪枝

- 展示了多个ΔW矩阵的并行剪枝

- 通过"..."表示可扩展性

- 保持关键连接的同时减少参数量

3. 参数冻结与共享(右二区域)

1.冻结策略

- 使用蓝色标注冻结参数

- 显示N(0,σ²)初始化方式

- 通过箭头指示参数共享关系

2.共享机制

- 展示了参数在不同层间的共享

- 使用相同颜色标注共享参数

- 通过"Frozen and Shared"标签明确状态

4. 参数量化(右一区域)

1.量化过程

- 展示了从浮点到定点的转换

- 使用不同颜色区分量化前后的权重

- 包含量化公式N(0,σ²)

2.特征说明

- "Frozen"标签表示固定参数

- "Trainable"标签表示可训练参数

- 通过颜色编码区分不同状态

这四种方法各具特色,共同构成了LoRA参数效率优化的技术体系:

- 参数分解关注降维

- 参数剪枝突出重要性

- 参数冻结与共享提高复用

- 参数量化优化存储效率

通过这些方法的组合应用,可以显著提升模型的参数效率,同时保持模型性能。图中的可视化设计帮助读者直观理解每种方法的工作原理和应用方式。

LoRA进阶技术:突破性能边界

参数效率提升:多维度的优化

研究者们提出了多种提升LoRA参数效率的方法:

1.参数分解:通过奇异值分解(SVD)或张量分解等技术,进一步压缩LoRA参数。例如,AdaLoRA通过动态调整奇异值的重要性来实现自适应的参数压缩。

2.参数剪枝:基于重要性评分对LoRA参数进行剪枝,如SparseAdapter通过多准则重要性评估来确定需要保留的参数。

3.参数量化:采用混合精度量化策略,如QLoRA使用4比特NormalFloat量化方法,在保持性能的同时进一步降低内存占用。

秩适应机制:动态调整能力

为了更好地适应不同任务的需求,研究者们开发了多种秩适应机制:

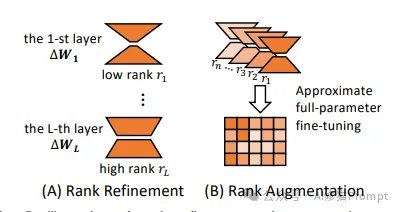

该图展示了两种重要的秩操作方法:秩细化(Rank Refinement)和秩增强(Rank Augmentation),通过可视化方式展现了它们的工作机制:

A. 秩细化方法(左侧)

1.层级结构

- 第1层ΔW1(顶部):展示低秩r1参数

- 中间使用省略号表示多层结构

- 第L层ΔWL(底部):展示高秩rL参数

2.特征说明

- 从上到下秩逐渐增加

- 使用三角形图形表示不同大小的低秩矩阵

- 通过垂直排列显示层级关系

B. 秩增强方法(右侧)

1.结构设计

- 左侧显示多个小型低秩矩阵

- 右侧展示近似全参数微调的网格矩阵

- 使用双箭头指示转换关系

2.技术特点

- 通过组合多个低秩表示

- 实现对全参数微调的近似

- 保持参数效率的同时提升表达能力

关键创新点

1.秩细化策略

- 自适应调整不同层的秩大小

- 根据层的重要性分配参数资源

- 实现更精细的参数控制

2.秩增强机制

- 通过组合多个低秩结构

- 近似实现全参数微调效果

- 平衡效率和性能的权衡

这两种方法展示了LoRA在秩操作方面的灵活性:秩细化关注层级化的参数分配,而秩增强则通过组合实现更强的表达能力。图中的几何表示和箭头指示帮助读者理解这些复杂的数学概念和转换过程。

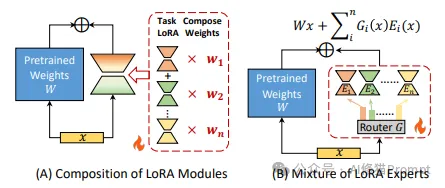

模块组合与专家混合:架构创新

LoRA技术在架构设计上实现了两个重要创新:

1.模块组合方法(左图)

- 通过权重系数(w1、w2、w3)组合多个LoRA模块

- 支持多任务学习和渐进式适应

- 提供灵活的模块复用能力

2.专家混合机制(右图)

- 采用混合公式:W'x = Σ Gi(z)Ei(x)

- 通过门控函数动态选择专家

- 实现条件化的适应能力

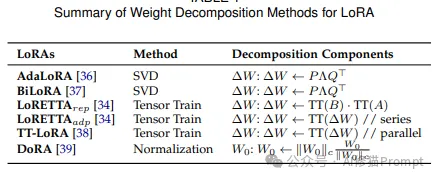

权重分解方法的演进

该表格总结了LoRA技术中不同的权重分解方法,展示了该领域的主要技术变体和创新:

1.基于SVD的方法

- AdaLoRA:通过自适应调整奇异值实现动态压缩

- BiLoRA:引入双向适应机制,提升模型表现

2.基于张量分解的方法

- LoRETTA_TT:利用张量列分解降低参数复杂度

- LoRETTA_TF:通过序列化处理提高计算效率

- TT-LoRA:支持并行计算的张量分解方案

3.其他创新方法

- DoRA:引入方向感知的适应机制,提升模型性能

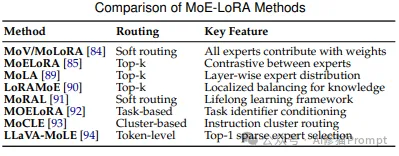

模块组合与专家混合:架构创新

MoE-LoRA在专家路由策略方面展现了多样化的发展,从简单的软路由发展到复杂的任务导向路由:

1.软路由方法

- MeV/MoLoRA:实现专家间的平滑权重分配

- MoRAL:支持终身学习的框架设计

2.Top-k路由方法

- MoELoRA:通过对比学习增强专家间差异性

- LoLA:采用层级化的专家选择机制

- MoLoRA:实现知识在专家间的有效分配

3.任务导向路由

- MOELoRA:基于任务特征选择专家

- MoCLE:引入指令感知的路由机制

- LLaWa-MoE:高效的单专家路由设计

这些路由策略为不同应用场景提供了灵活的解决方案,反映了研究者们在提升模型适应能力和效率方面的创新。

LoRA的创新应用:跨域突破

持续学习:克服灾难性遗忘

LoRA在持续学习领域展现出独特优势:

1.正交约束:O-LoRA通过确保新任务更新与之前任务正交来防止知识干扰。

2.任务算术:通过对LoRA参数进行向量运算来组合多个任务的知识。

3.集成学习:CoLoR通过维护多个任务特定的LoRA模块并使用原型匹配来实现灵活的任务适应。

联邦学习:隐私保护下的协同训练

在联邦学习场景中,LoRA提供了高效的解决方案:

1.隐私保护:FedIT和FFA-LoRA实现了保护隐私的指令微调框架。

2.异构处理:FedLoRA通过堆叠式聚合方法支持不同秩的适配器across异构客户端。

3.个性化:PER-PCS框架支持用户安全共享和协作组装个性化LoRA模块。

实践指南

选择合适的LoRA配置

1.秩的选择:

- 对于简单任务,通常rank=4-8就足够

- 复杂任务可能需要rank=16-32

- 特别注意任务的复杂度和数据量大小

2.学习率设置:

- 建议范围:1e-4到1e-3

- 可以使用学习率预热

- 监控训练损失来及时调整

3.层次选择:

- 注意力层通常是最重要的适应目标

- 考虑任务特性选择合适的层次组合

- 可以使用渐进式策略逐步增加适应层数

优化训练过程

1.数据准备:

- 确保数据质量和多样性

- 适当的数据增强可以提升泛化性

- 考虑使用验证集来监控过拟合

2.训练策略:

- 使用梯度累积来处理大批量

- 适当的预热和学习率调度

- 监控梯度范数来确保训练稳定性

3.内存优化:

- 使用梯度检查点来节省显存

- 考虑使用混合精度训练

- 合理设置批量大小

写在最后

LoRA技术的出现彻底改变了AI模型微调的范式,为Prompt工程师提供了一个强大而灵活的工具。通过深入理解LoRA的原理和最佳实践,开发者可以更好地利用这项技术来优化自己的AI应用。随着技术的不断发展和完善,我们有理由相信LoRA将在AI领域发挥越来越重要的作用。本文详细介绍了LoRA的核心技术、最新进展和实践指南,希望能够帮助您更好地理解和应用这项革命性的技术。

文章来自于“AI修猫Prompt”,作者“AI修猫Prompt”。

全部评论

留言在赶来的路上...

发表评论