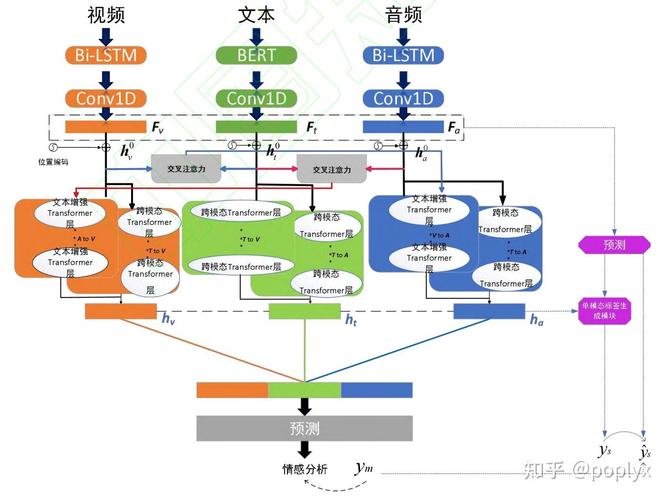

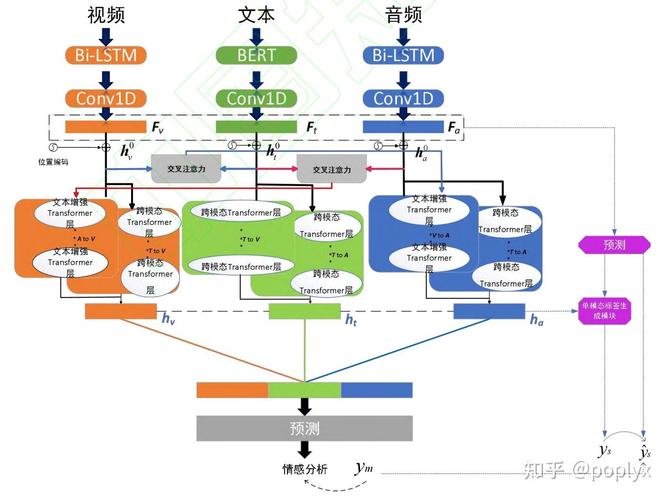

Emotion-LLaMA是多模态情绪识别与推理模型,融合了音频、视觉和文本输入,通过特定情绪编码器整合信息。模型基于修改版LLaMA,经指令调整以提升情感识别能力。研究者构建了MERR数据集助力训练与评估,使模型能从多场景学习并应用于现实。Emotion-LLaMA在多个数据集和挑战赛中表现优异,如在MER2024挑战赛MER-NOISE赛道中以84.52%的WAF超越其他团队。其架构设计巧妙,充分发挥LLaMA优势,纳入关键情感线索。

Emotion-LLaMA是多模态情绪识别与推理模型,融合了音频、视觉和文本输入,通过特定情绪编码器整合信息。模型基于修改版LLaMA,经指令调整以提升情感识别能力。研究者构建了MERR数据集助力训练与评估,使模型能从多场景学习并应用于现实。Emotion-LLaMA在多个数据集和挑战赛中表现优异,如在MER2024挑战赛MER-NOISE赛道中以84.52%的WAF超越其他团队。其架构设计巧妙,充分发挥LLaMA优势,纳入关键情感线索。

全部评论

留言在赶来的路上...

发表评论