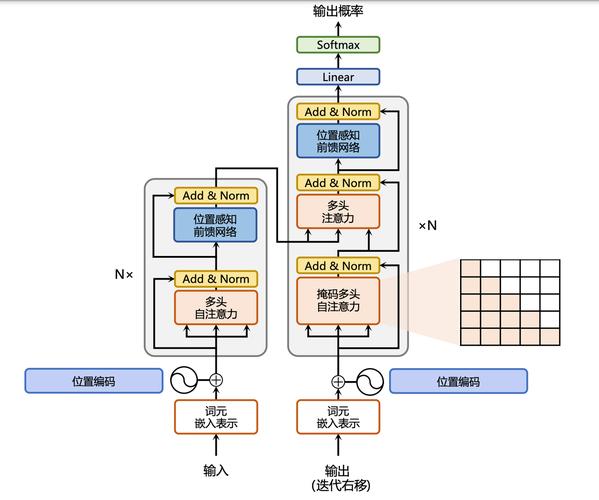

DuoAttention是新型的框架,由MIT韩松团队提出,用在提高大型语言模型(LLMs)在处理长上下文时的推理效率。基于区分“检索头”和“流式头”两种注意力头,优化模型的内存使用和计算速度。检索头负责处理长距离依赖,需要完整的键值(KV)缓存,流式头关注最近token和注意力汇聚点,只需固定长度的KV缓存。两种注意力头让DuoAttention在保持模型准确性的同时,减少内存消耗和提高解码及预填充的速度。结合量化技术,DuoAttention能在单个GPU上实现高达330万token的上下文推理,是处理长文本信息的有效方案。

全部评论

留言在赶来的路上...

发表评论