ARTalk是东京大学和日本理化学研究所推出的新型语音驱动3D头部动画生成框架,基于自回归模型实现实时、高同步性的唇部动作和自然的面部表情及头部姿势生成。ARTalk用多尺度运动码本和滑动时间窗口技术,结合语音输入生成高质量的动画序列。ARTalk引入风格编码器,适应未见说话风格,生成具有独特个性的3D动画。ARTalk在唇部同步精度、表情自然性和风格一致性方面优于现有技术,具备实时性,适用于虚拟现实、游戏动画和人机交互等领域。

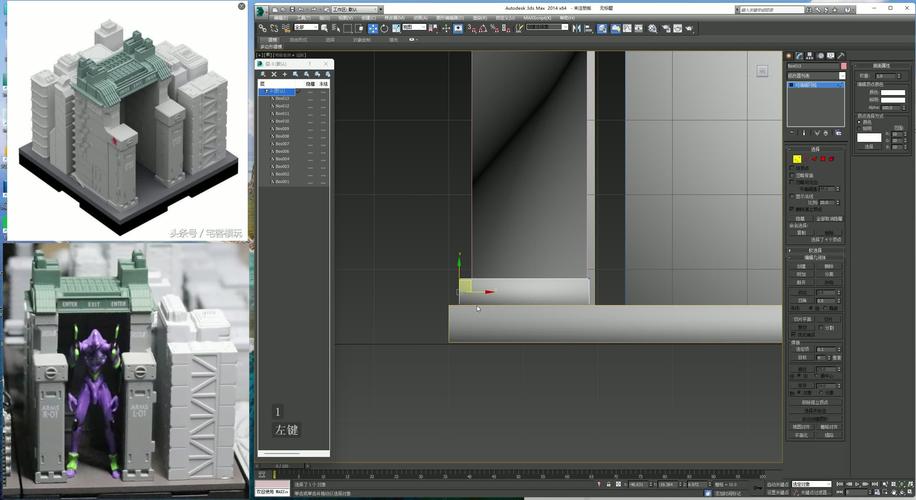

(图片来源网络,侵删)

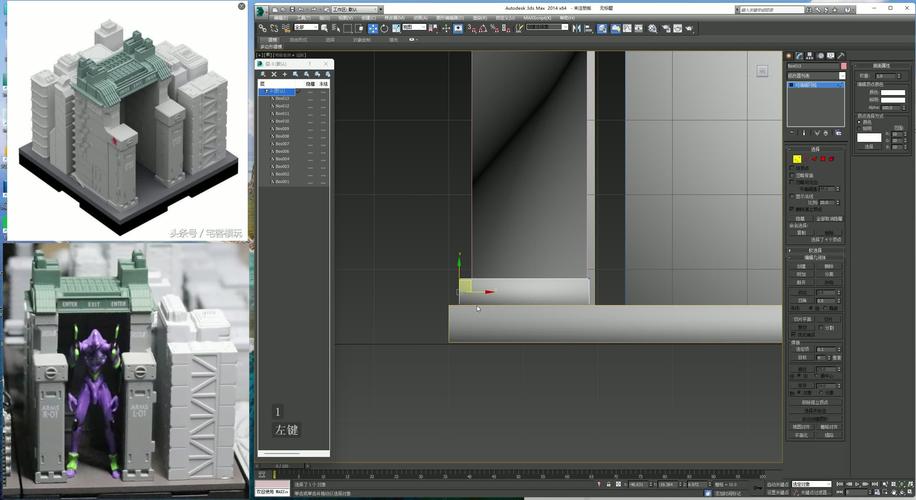

(图片来源网络,侵删)

ARTalk是东京大学和日本理化学研究所推出的新型语音驱动3D头部动画生成框架,基于自回归模型实现实时、高同步性的唇部动作和自然的面部表情及头部姿势生成。ARTalk用多尺度运动码本和滑动时间窗口技术,结合语音输入生成高质量的动画序列。ARTalk引入风格编码器,适应未见说话风格,生成具有独特个性的3D动画。ARTalk在唇部同步精度、表情自然性和风格一致性方面优于现有技术,具备实时性,适用于虚拟现实、游戏动画和人机交互等领域。

全部评论

留言在赶来的路上...

发表评论