token处理

-

发布了文章 2个月前

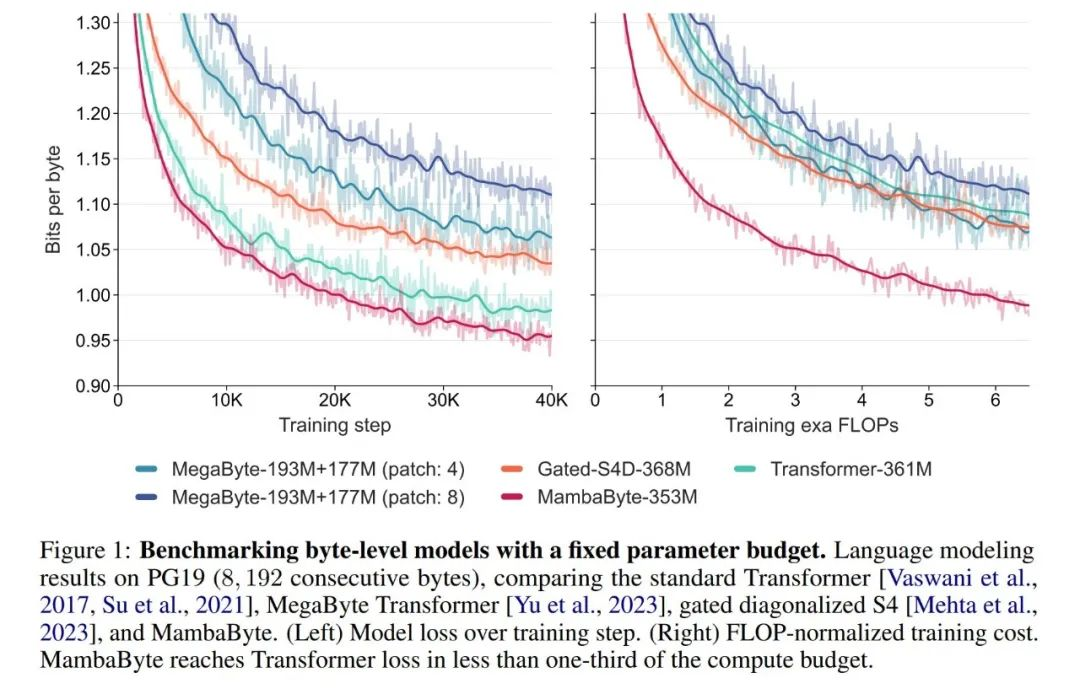

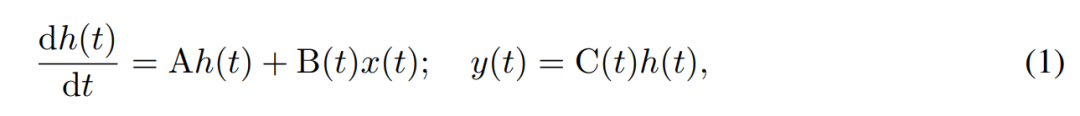

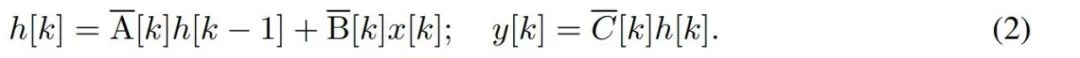

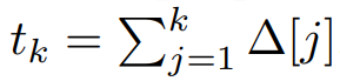

不分割成token,直接从字节中高效学习,Mamba原来还能这样用

不分割成token,直接从字节中高效学习,Mamba原来还能这样用 给出一句「Hello, world!」你要怎么把它喂给 AI 模型?目前常见的方法是利用某种算法将它分为若干 token,比如 ["Hello", "...

-

发布了文章 2个月前

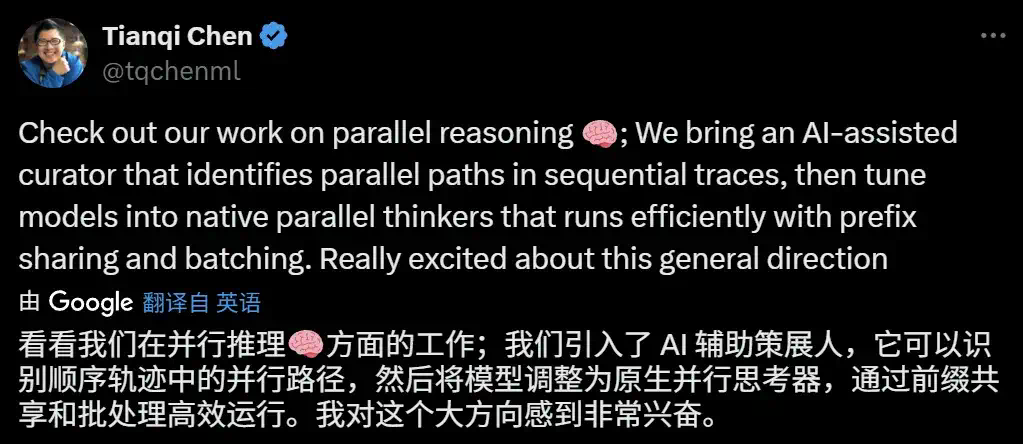

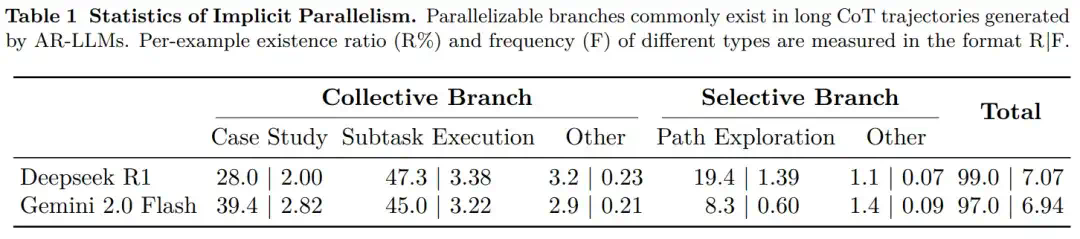

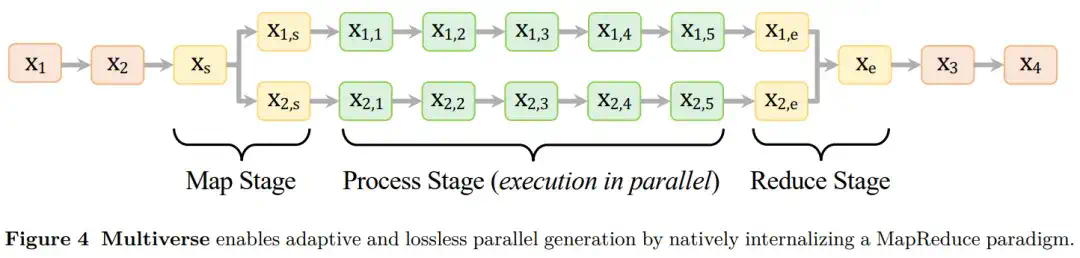

逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse

逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse 原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。众所周知,大语言模型的参数量越来越大,算力需求也越来越可怕,...

-

发布了文章 2个月前

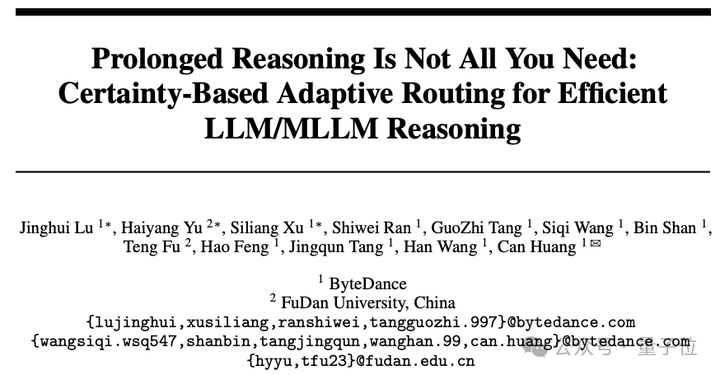

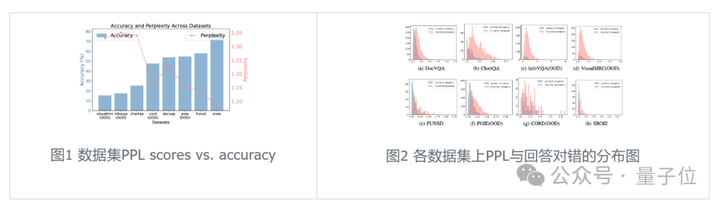

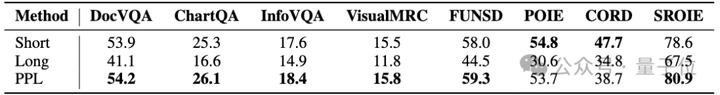

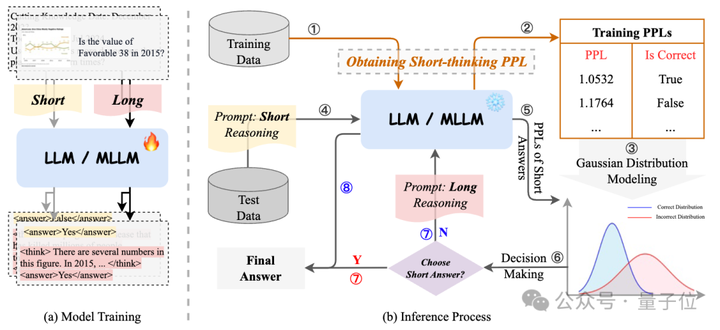

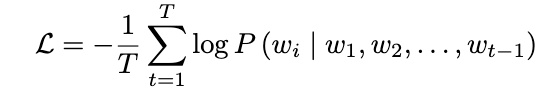

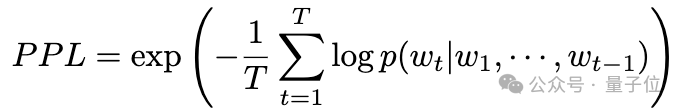

低Token高精度!字节复旦推出自适应推理框架CAR

低Token高精度!字节复旦推出自适应推理框架CAR 过度依赖CoT思维链推理会降低模型性能,有新解了!来自字节、复旦大学的研究人员提出自适应推理框架CAR,能根据模型困惑度动态选择短回答或详细的长文本推理,最终实现了...

没有更多内容