微软mos

-

发布了文章 2个月前

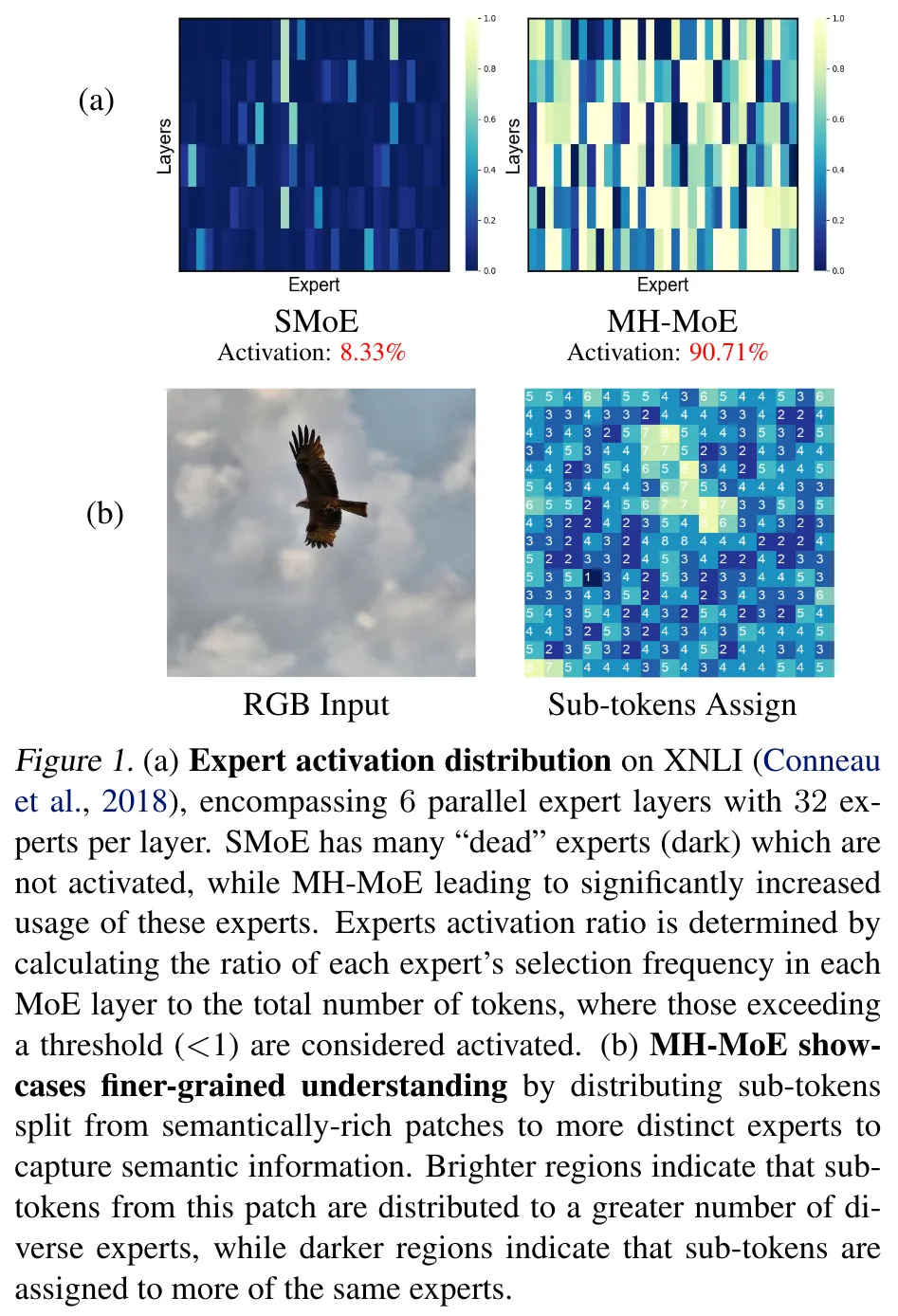

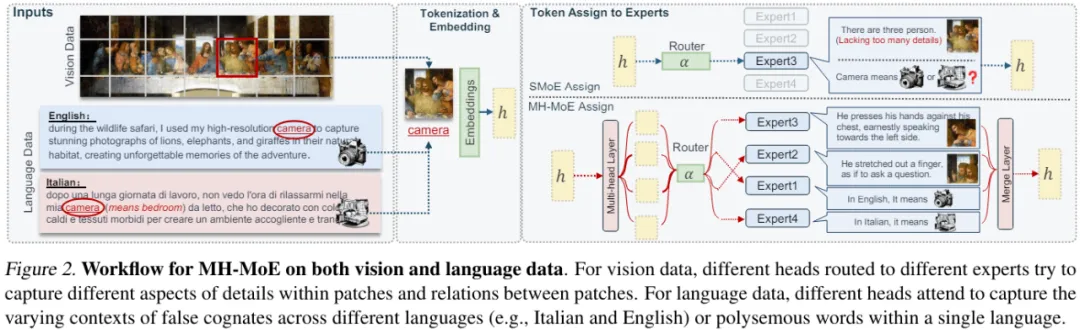

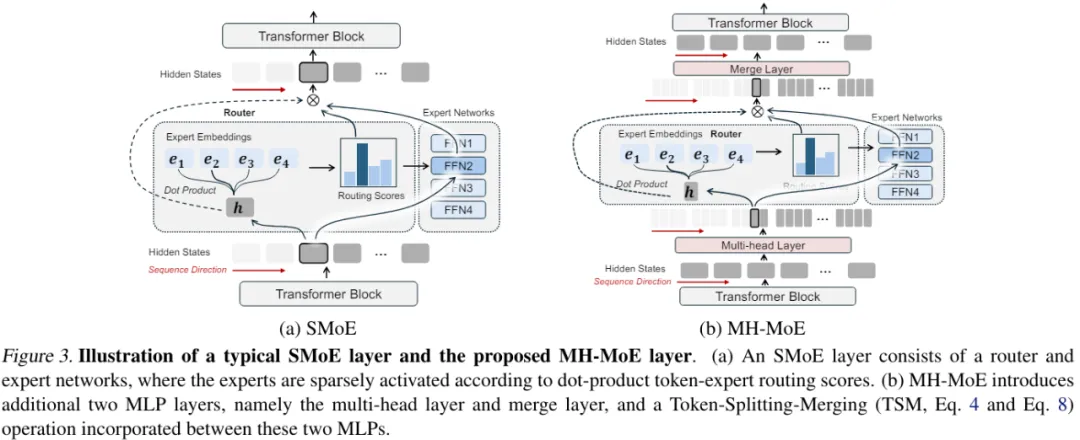

微软让MoE长出多个头,大幅提升专家激活率

微软让MoE长出多个头,大幅提升专家激活率 混合专家(MoE)是个好方法,支持着现在一些非常优秀的大模型,比如谷歌家的 Gemini 1.5 以及备受关注的 Mixtral 8x7B。稀疏混合专家(SMoE)可在不显著...

-

发布了文章 2个月前

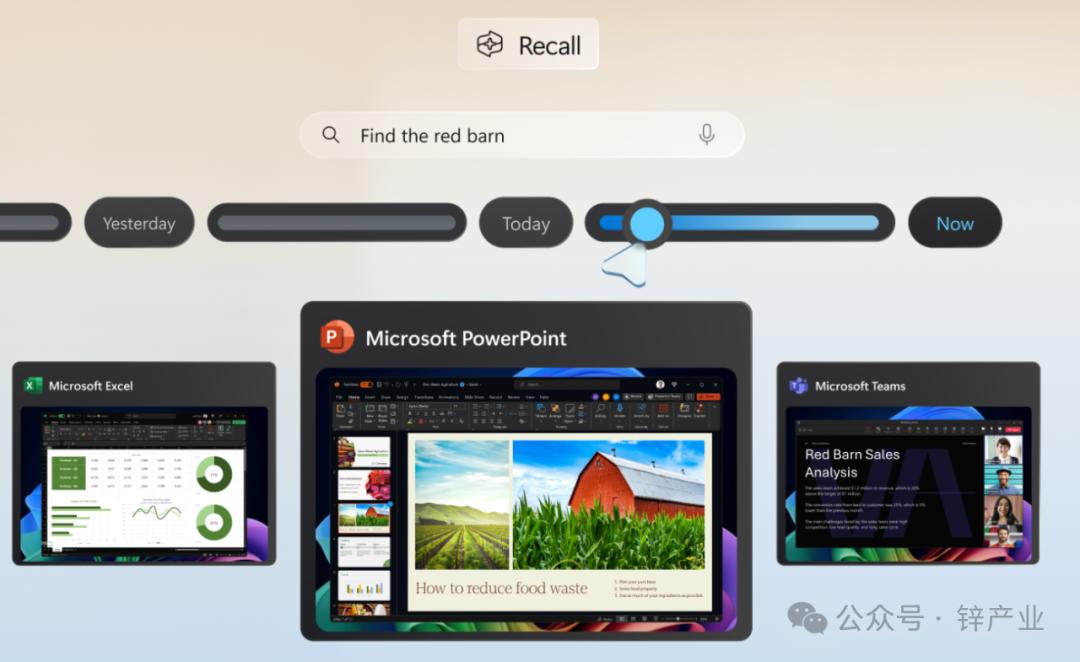

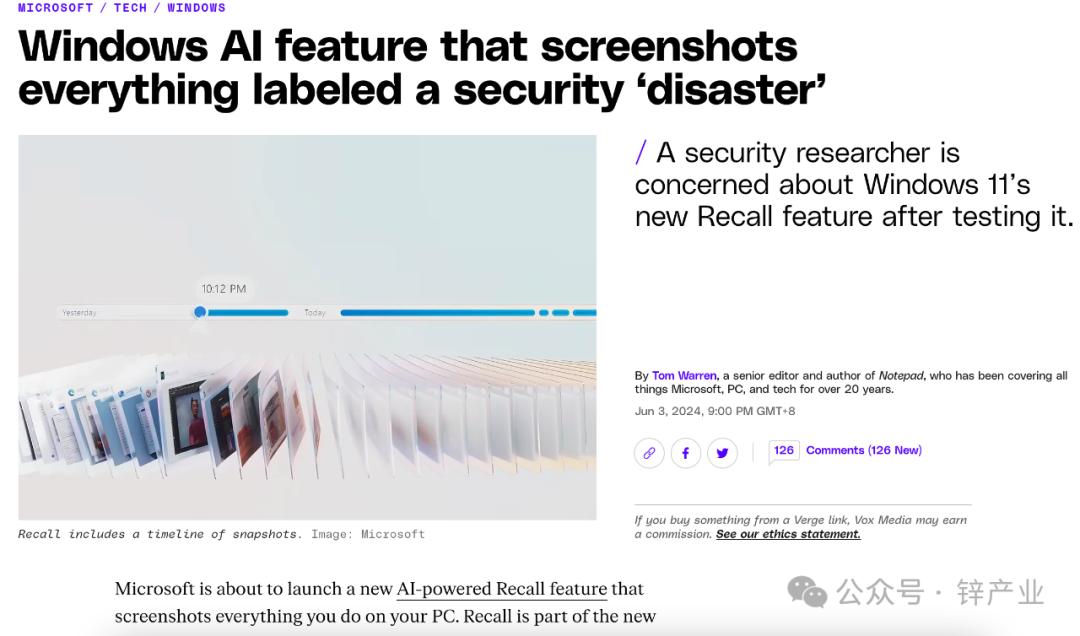

微软们掉进大模型安全漩涡

微软们掉进大模型安全漩涡 大模型的安全问题正在悄悄逼近。就在全球都在因大模型而狂欢时,大模型的安全问题也随之来临。不过,科技发展向来是一个不可逆的过程。...

没有更多内容